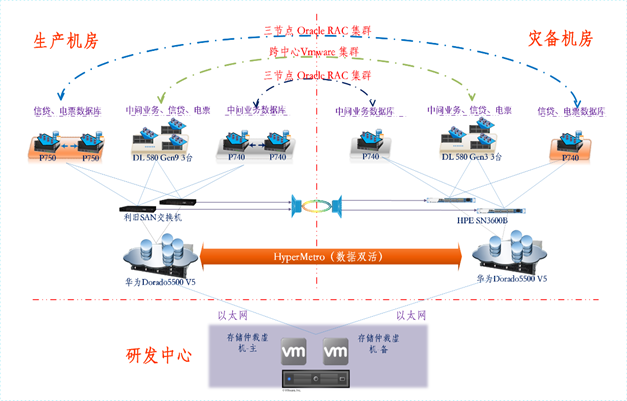

灾备建设主机及存储架构规划如下:

- 所有业务系统运行环境采用全新部署的方式进行部署建设。即将现有业务系统结合全新改造及升级改造的方式在本项目部署的基础资源环境上完成部署及迁移上线工作;

- 规划利旧使用6台HPE DL580 Gen9服务器,生产机房及灾备机房各部署3台,共同构建一个跨数据中心的VMware虚拟化集群环境。将信贷系统、中间业务系统及票据系统应用环境部署在该虚拟化资源池。通过vmware的vMotion技术+vsphere HA技术实现容灾切换。

- ESB与CBUS系统采用现有生产中心4台RH5885H V5与容灾中心利旧4台DL580 Gen9服务器共同构建一个跨数据中心的VMware虚拟化集群环境。ESB与CBUS系统均部署在改虚拟化资源池中。通过vmware的vMotion技术+vsphere HA技术实现容灾切换。

- 规划信贷系统、中间业务系统及票据系统的数据库采用物理机部署方式,利旧6台小型机,按照容灾2:1的比例,信贷和票据系统数据库在生产中心配置2台P750(每台运行2个分区),容灾中心配置1台P740(运行2个分区),3台机器组成用于信贷及票据系统的两套3节点RAC集群;中间业务数据库生产中心配置2台P740,容灾中心配置1台P740,3台机器组成1套3节点RAC集群;

- 所有业务系统数据在主生产中心存放在主中心的数据存储上,同城容灾端同为Dorado5500V6存储。然后利用存储HyperMetro功能实现生产中心至同城容灾中心的双活数据同步;

- 利旧生产中心2台SAN交换机与容灾中心2台SAN交换机之间利用运营商链路构建级联,提供数据同步及主机互访的SAN网络环境。

- 针对业务系统的数据库环境,当联通生产中心业务系统站点故障情况下,由于存储数据已由存储实现底层同步,直接启动同城容灾中心数据库即可实现容灾切换。

- 针对业务系统的VMware虚拟化环境,由于存储数据已实现底层同步,业务系统虚拟机由vsphere集群保护,在出现站点级故障时,会自动切换至同城容灾中心的主机上启动业务系统虚拟机。

根据监管和该银行灾备切换演练需求,此次网络规划采用双活数据中心设计,建立灾备数据中心来承载相关业务系统,其主要目的是为了实现应用的高可用性,且能同时满足灾备切换演练。

- 网络冗余设计:生产与灾备汇聚分别采用波分链路实现二层互通,将同一个网络扩展到灾备数据中心,并通过HSRP技术实现网络网关冗余,新双活网络架构,实现双中心应用系统业务实时迁移,并且能为用户提供服务,当某个数据中心的应用系统出现故障时,有另一个数据中心的应用来持续的提供服务,大大提高了业务系统的同城容灾能力。

- 业务分区设计:根据三套系统应用架构的升级改造需求,我们按系统的逻辑应用关系,综合应用现状分别在生产和灾备各新增1套接入环境,分别接入相应服务器资源,全新规划APP/DB安全区域,并且三套业务系统能够平滑迁移到新网络安全域中实现容灾切换。

- 应用负载设计:针对生产与灾备中心2个业务区,分别使用了6台负载均衡,生产中心使用4台负载设备,部署在新建的APP/DB安全域内,灾备中心使用2台负载均衡部署在新建的APP/DB安全域内。采用2:1形式旁挂部署在每个区域的汇聚交换机上,双中心负载均衡设备通过波分链路实现跨中心集群部署,通过负载均衡对双中心应用系统的感知,实现跨数据中心的应用的调度。

- 地址规划设计:由于考虑到后期业务是逐步迁移的方式,建议此次改造的网络地址全新规划,方便后续老生产网络安全域平滑迁移到新建安全域中,减少对生产业务的影响,同时建议前置、APP、DB划分为不同网段,对应用进行逻辑隔离,方便后期扩容,业务逻辑关系清晰,同时满足监管要求。